AGENDA I AULAEN: WILLIAM MACASKILL

Longtermisme er ideen om at vi skal ta hensyn til fremtidens befolkning, når vi tar beslutninger i dag, og begrepet har skapt stor interesse de siste årene. Tankesmien Agenda og Universitetet i Oslo inviterte professor William MacAskill til å holde årets «Agenda i Aulaen»-forelesning.

Foredraget er oversatt av Henrik Wathne og Henrik Heitmann

Tittelen på dette foredraget er «Hva skylder vi fremtiden?». Jeg kommer til å fokusere på én ting som jeg har dvelt ved siden boken min ble utgitt: fremskritt innen kunstig intelligens og hva kan vi forvente hvis fremskrittet fortsetter.

Ofte undervurderer vi hvor fort tinge vil utvikle seg, spesielt ideen som gjerne kalles «intelligenseksplosjonen». Intelligenseksplosjonen vil kunne fremskynde århundrer av teknologisk fremskritt i løpet av bare måneder eller år. Det vil medføre mange utfordringer og jeg vil gjerne komme med et forslag til hvordan vi bør navigere oss i denne tidsalderen – en idé jeg kaller for den globale konstitusjonelle konvensjonen.

La oss starte med en oppsummering av de nylige fremskrittene som er gjort for kunstig intelligens – som fort tar pusten fra en. Her er et KI-generert bilde fra april 2022 (Bilde 1). Jeg ga modellen denne instruksen: «den rødhårete kvinnen har solbriller og står med frihetsgudinnen i bakgrunnen, et fotografi». Som dere kan se, så gjør modellen en helt grei jobb. Den lager en kvinne som har rødt hår, men den klarer åpenbart ikke helt å forstå «frihetsgudinne». Den skjønner at statuen har pigger, men den putter det på kvinnens hode, ikke frihetsgudinnens. Så modellen forstår noen begreper, men det er tydelig at den ikke helt skjønner hva som foregår. Dette var i april 2022.

Mindre enn et år senere får modellen samme instrukser, og nå lager den dette (Bilde 2). I løpet av kun ett år har disse billedgeneratorene gått fra å ha en veldig dårlig forståelse for ting og gjenstander i verden, til å kunne generere en nærmest perfekt gjengivelse av dem. Det tok meg lang tid før jeg klarte å se noe på bilde som faktisk ville vise at dette bilde er uekte eller KI skapt – som dere ser, er det én pigg for mye på frihetsgudinnens hode.

Så det var billedgenerering, som har blitt veldig imponerende. Enda mer imponerende, etter min mening, er de store språkmodellene, som jevnt og trutt har utviklet over årene, men som ble viden kjent med ChatGPT. Enda mer imponerende var GPT4, som for meg ser ut til å engasjere seg i resonnering på høyt nivå på samme måte som vi mennesker gjør. Dette var en stor overraskelse for meg, og er en utvikling som har gått mye raskere enn jeg forventet.

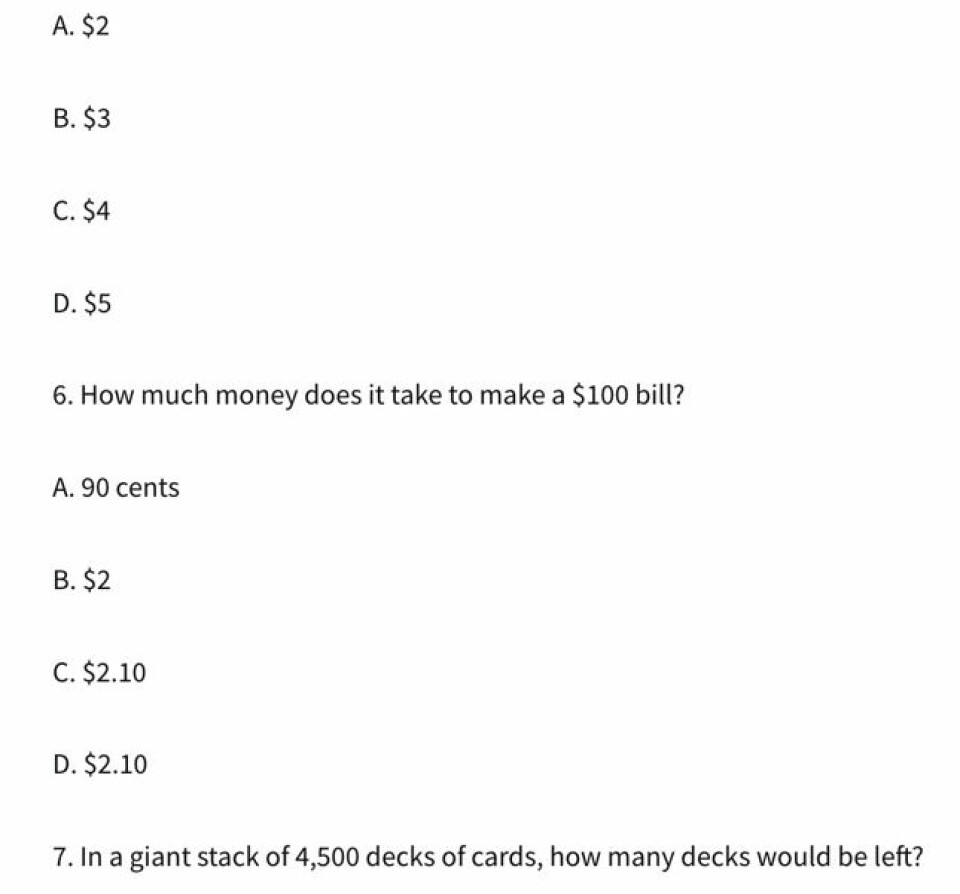

Igjen vil jeg demonstrere dette raskt, og den fremgangen KI har gjort over de siste fire årene. Her er en enkel gåte: kunstforhandleren kjøpte et maleri for 7 dollar, solgte det for 8 dollar, kjøpte det tilbake for 9 dollar, og solgte det for 10 dollar. Hvor mye profitt fikk kunstforhandleren?

Jeg stilte dette spørsmålet til GPT4 nylig, og den ga helt korrekt svar, med helt riktig tankerekke. Hvis du kjøper et maleri og selger det for en dollar, så gir det en dollar i profitt. Hvis du gjør det samme igjen, så får du enda en dollar i profitt. Du får totalt to dollar.

Jeg var nysgjerrig på hvordan de tidligere versjonene av disse språkmodellene klarte seg på samme oppgave. Jeg stilte derfor GPT2 samme spørsmål – en tidligere versjon av språkmodellen fra fire år tidligere. GPT ga umiddelbart riktig svar. Men! Dette er det fullstendige svaret jeg fikk:

Som dere ser spyr språkmodellen ut masse ideer, inkludert ting som er fullstendig irrelevant. Det gir ingen mening. Og selv med disse eksemplene har jeg vært selektiv. Et typisk svar fra GPT2 på slike spørsmål var «Slik var min morgen i New York!» Modellen snakker til deg på en måte som din eldre bestefar kunne ha funnet på. Den forteller deg en historie helt urelatert til spørsmålet som ble stilt.

For fire år siden var dette en imponerende bragd. Det var en språkmodell som var i stand til å danne grammatiske setninger. Men den hadde ikke egentlig begreper som å kjøpe og selge kunst, eller om matematikk for den saks skyld. Likevel var det en enorm utvikling. Og dette hjelper oss å se hvor stort fremskritt vi har gjort i løpet av kun fire år: Fra språkmodeller som ikke hadde noen tankeevne overhode, til å faktisk kunne engasjere seg i resonnering på ganske høyt nivå.

Dette nivået av fremskritt har gjort verden ganske oppskaket: Demonstrasjoner har blitt avholdt for å bremse KI, det kom nye presidentordre fra Biden, det ble avholdt møte om KI-sikkerhet i Storbritannia, protestbevegelser har mobilisert seg, og så videre.

Men likevel tror jeg ikke at verden helt har tatt inn over seg helt hvor mye raskere utviklingen kan skje i fremtiden. Situasjonen føles for min del noe lik den tidlige fasen av COVID-19 pandemien, hvor folk begynte å bli smittet og folk ble opprørt over økende dødsfall. Likevel tok man ikke inn over seg den eksponentielle kurven, og at ting kom til å bli mye villere. Og denne ideen, om at ting vil bli villere, har vært kjent siden femtitallet som «intelligenseksplosjonen». Den tilsier at raten av intellektuell utvikling, av teknologisk fremskritt, og fremskrittet til KI kan gå veldig raskt når man når en viss terskel. Det er dette sporet jeg vil forfølge videre.

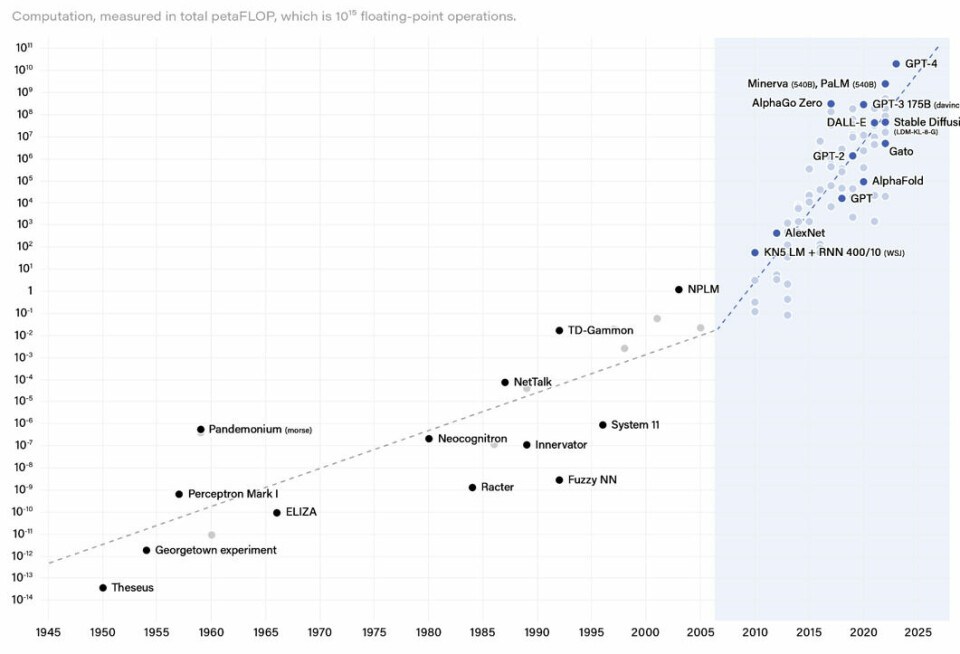

Når vi ser hvor mye fremskritt som har skjedd på KI-feltet, lar det seg best oppsummeres av følgende graf:

Tiden er på x-aksen og den totale utregningskraften på y-aksen. Legg merke til at hver strek på aksen er en tidobling – det er med andre ord en logaritmisk skala. Det har altså vært en enorm økning i investering i treningen av disse KI-systemene over de siste ti årene. Det er rundt en milliard ganger økning i mengden utregningskraft som vi bruker til å trene disse modellene. Det at vi får en så pålitelig forbedring av ytelsen til disse systemene ved å, i bunn og grunn, bare kaste mer og mer utregningskraft på dem og trene større modeller med mer utregningskraft over lengre tid, kalles for «skaleringshypotesen».

Man kunne ha trodd at arbeid innenfor KI feltet ene og alene har blitt drevet frem av utrolig innsiktsfulle gjennomslag – ting som ikke helt enkelt kan gjenskapes. Men det viser seg, i hvert fall for øyeblikket, at dette ikke er tilfelle. Det er heller en ingeniørutfordring – det handler om å få det mest grunnleggende på plass, og virkelig investere en enorm mengde utregnelseskraft på problemet.

Her er vi nå. Vi kan, selvsagt, ekstrapolere denne trenden inn i fremtiden. Vi kan også sammenligne trenden med referanse til de ulike hjerner vi finner i dyreriket som vi kjenner til. Vi passerte milesteinen for å trene ekvivalenten av hjernen til en honningbie for noen år tilbake, men vi har ennå ikke kommet til det tidspunktet hvor språkmodeller eller andre KI-systemer er like kraftfulle som menneskers hjerne. Dette overrasket meg når jeg først hørte det – jeg trodde i utgangspunktet at datamaskiner var blitt så kraftige at vi hadde passert dette punktet for lenge siden, og at forskjellen måtte bero på at hjernen vår er så spesiell. Det viser seg snarere at enorme mengder utregningskraft foregår i hjernene våre, og selv om vi kan forvente at hjernen opererer med mer effektive algoritmer enn dagens KI-systemer, er dette kanskje bare en gradsforskjell, snarere enn en typeforskjell.

Vi nærmer oss med andre ord et tidspunkt hvor vi trener modeller som er like kraftfulle som menneskets hjerne. Vi er ventet å nå samme kraftfullhet allerede i tidlig 2030-årene. Hva vil skje når vi passerer denne terskelen?

Når vi krysser dette punktet vil vi ha modeller som potensielt kan utføre brorparten av oppgavene som mennesker utfører i dag – i det minste de samme kognitive oppgavene. Det inkluderer vitenskap og ingeniørarbeid. Det inkluderer arbeid som dataingeniør og det å trene maskinlæringsmodellene selv. Hva skjer da?

For å forsøke å tenke på dette kan vi se tilbake på utviklingen av teknologi gjennom menneskets historie. Hva slags historie ligger bak den teknologiske utviklingen frem til i dag?

Jeg tror dette er en historie om en selvforsterkende prosess. De første teknologiene var verktøy av flint, spyd og ild. Deretter fikk vi landbruk og etter hvert industriell teknologi, kunstgjødsel, traktorer og andre teknologier. Bedre teknologi tillot større populasjonen. Hvor vi i tiden med jeger-sanker samfunn bare hadde en populasjon på rundt 10 millioner mennesker, er verdens befolkning nå rundt 8 milliarder. Dersom vi i dag hadde vært jeger-sankere, hadde det ikke gått å ha 8 millioner mennesker i verden – vi kunne simpelthen ikke ha produsert nok mat. Men vi har vært i stand til å bruke teknologi til å produsere mer ressurser, som igjen betyr at vi kan brødfø en større verdensbefolkning. Det betyr også flere mennesker som kan bedrive vitenskap, innovasjon og forskning- og utviklingsarbeid.

Blant de beste økonomiske modellene for langsiktig vekst, tror jeg dette er nøkkelen for å beskrive denne dynamikken. Mer og bedre teknologi avler flere mennesker som kan bedrive forskning, som igjen fører til mer teknologi. Og den eksponentielle trenden vi ser i dag er et resultat av dette. Folk snakker mye om eksponentiell vekst. Vi er vant til at økonomien vokser omkring 2% hvert år. Men i det lange løp har vi faktisk vokst raskere enn dette. Det kalles super-eksponentiell vekst. Man kan ikke engang se en økning i global velstand før vi gikk forbi den industrielle revolusjon for 250 år siden.

Med andre ord: Det vi vi får fra en slik selvforsterkende prosess, er menneskelig fremskritt og teknologisk utvikling over tid. Akkurat det samme kan skje med KI-systemer, hvor man får bedre og bedre kunstig intelligens. Vi er riktignok ikke der enda, men det kan skje i løpet av de neste årene. KI tillater oss å betraktelig forbedre utregningskraften vi får ved å designe bedre databrikker, og ved å forbedre algoritmene. Dette betyr at vi vil få flere KI-forskere, og disse kan igjen forbedre KI, som igjen kan lede til mer utregningskraft og algoritmer. Og denne selvforsterkingsprosessen vil være mye raskere enn de selvforsterkingsprosessene vi har hatt tidligere med menneskelig teknologisk utvikling – hvor det tar 20 år å oppdra et menneske. Med en gang du trener en modell som er på størrelse med den menneskelige hjernen, så kan du umiddelbart kjøre den, hundre millioner ganger. Så snart vi har den første KI-vitenskapsmannen, eller den første KI-dataingeniøren, vil vi ha hundre millioner kopier, som leder til en radikal økning i den virksomme arbeidskraften, som igjen vil designe all slags forbedret teknologi samt KI, som igjen vil forbedre KI og så videre.

Hvis du zoomer inn på nåtiden, la oss si de siste 50 årene, så har økonomisk vekst vært omtrent eksponentiell. Hvis vi plugger dette inn i ganske standard økonomiske modeller får vi den samme eksplosive veksten som vi har sett over de siste 2000 årene, men nå skjer det i mange ganger større skala, over bare år eller til og med måneder.

Ikke lenger sci-fi

Som dere vet handler dette foredraget om hva vi skylder fremtiden, om longtermisme, som jo ofte er forstått som det å tenke grundig på fremtiden, og på hva som vil skje i de kommende århundrer. Men hvis hypotesen om «intelligenseksplosjon» er riktig – og jeg sier ikke at det er uunngåelig – så vil flere århundrer med teknologisk utvikling skje i løpet av bare få år. Så du kan like gjerne tenke deg at den langsiktige fremtiden faktisk er her og nå, om kort tid. Og dette medfører enorme utfordringer.

En av disse utfordringene har nylig blitt velkjent, og det er risikoen fra KI. Hver gang jeg snakker om eksistensiell risiko fra KI, så bruker jeg dette bildet av «The Terminator». Bilder som dette pleide å være populære i media før ChatGPT, men media har blitt mer forsiktige nå. Nå virker slike bilder litt virkeligere, litt mindre sci-fi. Men jeg elsker fortsatt dette bildet. Tenk hvis vi har en veldig mektig KI-robot som vil ødelegge menneskeheten – hvorfor ville den bygget disse menneskelignende robotene og gi dem skremmende, røde øyne?

Dette er ikke en risiko som kan bli avfeid som sci-fi. Det har faktisk blitt virkelighet i det siste, og langt mer akseptert. I et åpent brev fra Senter for KI-sikkerhet skriver de at «å redusere risikoen for menneskehetens utryddelse bør være en global prioritet». Det er signert av nærmest alle de mest sentrale navnene i KI-verdenen. De to øverste navnene, Geoffrey Hinton og Yoshua Bengio, er sett på som gudfedrene av KI. Også at ledelsen i de ledende AI-firmaene signerte brevet. Dette er som om Exxon, British Petroleum og Texaco sine ledere hadde skrevet et brev på 70tallet hvor de sa at «ja, produktene vi lager forårsaker katastrofale klimaendringer som bør være en global prioritet, som å forhindre atomkrig». Dette har nå skjedd for KI.

Jeg har derimot ikke bare lyst til å fokusere på risikoen for KI kommer til å «ta over». Det er nemlig bare én av mange risikoer vi står overfor. Dersom vi tar intelligenseksplosjonen seriøst, tenk på alle utfordringene vi må løse på bare noen måneder eller år. Hvis teknologien hadde gått sin vante gang hadde vi hatt god tid til å møte utfordringer fra ny teknologi. Nå har vi plutselig veldig kort tid på å løse de.

Hvilke utfordringer skaper KI?

Én utfordring er at vi skaper maskiner som potentielt er mye smartere og mer kapable enn oss mennesker. Dette er en prosess som kan gå veldig raskt, fra en KI som er omtrent like smart som et menneske til et KI-system som er langt smartere enn hele menneskeheten samlet. Så dette skaper en enorm og viktig utfordring.

Men vi møter andre utfordringer også. Hvis disse KI-systemene kan lage ny teknologi raskt, vil det også innebære masseødeleggelsesvåpen også. Vi ser allerede konturene av dette, og alarmen er slått på innen syntetisk biologi. Man kan ta en av disse språkmodellene, hacke dem for å unngå sikkerheten, og spørre dem: «hvordan designer jeg kopper-virus?» og så vil noen av modellene fortelle det. De er fortsatt ikke spesielt nyttig sammenlignet med Google, men de vil bli langt kraftigere over tid. Det betyr at vi kan få kraftigere biologiske våpen – og at de ikke bare er forbeholdt ekspertene. Forestill deg at jeg hadde et helt forskningslaboratorium på datamaskinen min, eller hundre millioner forskere som jobber med en hvilken som helst teknisk utfordring jeg gir dem. Det er skremmende, og det er virkelig ikke noe vi har hatt å gjøre med så langt.

Og det er bare én type mulig masseødeleggelsesvåpen. Sannsynligvis vil det bli utviklet mange flere i løpet av denne perioden, med eksplosiv teknologisk fremgang – inkludert ting vi ikke engang har tenkt på ennå – på akkurat samme måte som ideen om kjernevåpen var praktisk talt ukjent bare noen få tiår før det ble utviklet.

En annen utfordring er konsentrering av makt. Vi nevnte tanken om ulikhet, og at ulikhet kan være en naturlig bivirkning av utvikling. Har vi ikke allerede svært stor ulikhet? Jeg tror at vi har det, og at ulikheten vil kunne bli enda mer ekstrem i fremtiden. Nå lever vi i en tid med demokrati, og vi kan spørre oss om hvorfor det nesten ikke har eksistert demokratier i vår historie. En av grunnene er at det er økonomisk lønnsomt å ha en relativt lik distribuering av politisk makt, fordi de fleste kan bidra produktivt til samfunnet og frembringe nye idéer.

Det er også tilfelle at militær makt er relativt likt fordelt i dagens samfunn. Det er ikke tilfeldig at demokratisering skjedde samtidig som utviklingen av våpen. Hvis en politisk leder ønsker å bli diktator må hen vurdere muligheten for at et helt militære eller politi kan være uenige i det. Dette kan endres drastisk med KI. I stedet for å ha et menneskelig militære og politi, kan det automatiseres. I prinsippet kan all militær makt kontrolleres av bare én person – og det er en ganske skremmende utfordring.

I en verden med KI på nivå med – eller høyere – enn mennesker vil vi heller ikke trenge en menneskelig arbeidsstyrke for å drive økonomien fremover. KI-en kan gjøre alt. Så det teknologiske bakteppet som gjør demokrati ønskelig i denne verdenen, faller plutselig bort.

Og dette er bare én måte for å konsentrere militærmakt eller politisk makt i denne verdenen. Fordi, igjen, århundrer med fremskritt kan skje på bare noen få år. Eksempelvis kan vi få en konkurranse om rombosetting. Det er virkelig ikke vanskelig når du har AI-systemer som kan sendes ut i verdensrommet. AI-systemer, i form av roboter, kan i prinsippet trives i rommet på en måte som mennesker ikke kan, fordi de ikke trenger en atmosfære. Likevel er det enormt flere ressurser utenfor jorden: Sola produserer milliarder ganger så mye solenergi enn det som treffer jorden. De første menneskene som virkelig griper romressurser, kan få stor makt.

En global konvensjon som løsning

Når alle disse utrolige teknologiske utviklingene skjer på så kort tid, blir vi nødt til å ta mange moralske valg. Hvilke rettigheter skal disse KI-systemene ha? Man vil kanskje tenke at «disse er bare modeller, de er dataprogrammer, og de bør bli behandlet som det». Men hvis vi virkelig skaper vesener med følelser, så er det som å skape et nytt slavesamfunn, med vesener som kanskje er bevisste og fortjener moralsk respekt. På en andre siden, hva om vi gir dem et fullt sett av rettigheter, inkludert rett til å stemme? Siden de kan kopiere seg selv mye raskere enn mennesker, vil de raskt kunne ta over vår politiske makt.

Dette er en enorm utfordring, og jeg har faktisk ingen anelse om hvordan vi bør håndtere den. Og jeg tror vi vil ha enda mindre anelse dersom vi må ta disse beslutningene raskt. Så hva skal vi gjøre når vi står overfor utsikten til en intelligenseksplosjon? Jeg skal foreslå en spesifikk idé: ideen om en global konstitusjonell konvensjon.

Hva er det vi trenger for å navigere og styre denne intelligenseksplosjonen? Mange av disse utfordringene vil menneskeheten kunne håndtere med litt tid. Så en viktig ting vi kan gjøre, er å bremse utviklingen. Vi gjorde ikke en flott jobb med å styre atomvåpen, men vi har klart å overleve uten tredje verdenskrig så langt. Og det ville vært mye vanskeligere hvis utviklingen av våpnene hadde tatt måneder heller enn år og tiår.

Så vi ønsker å bremse utviklingen for å gi oss mer tid til å reagere, og der det er mulig, bør vi holde mulighetene åpne. Med en gang vi gir alle muligheten til å lage nye biovåpen er det vanskelig å trykke tannkremen tilbake inn i tuben. Med en gang vi lar en enkelt politisk leder få all makt, er det vanskelig å ta makten tilbake. Vi bør derfor lage et system som holder mulighetene åpne, og et system som inkluderer alle i beslutningene. Vanligvis ville disse beslutningene bli tatt av en håndfull av firmaer eller myndigheter, så tror jeg også at vi bør inngå forpliktende styringsavtaler på forhånd.

Hvis det er tilfellet at vi får denne intelligenseksplosjonen, så vil et godt utfall være veldig godt. Et godt utfall kan gjøre at vi lever lange, friske liv uten lidelse og at vi frigjøres fra kjedelig arbeid. I prinsippet kan vi alle leve fantastiske liv og få alt vi vil ha. Men det er bare tilfellet hvis vi håndterer dette på en god måte. Derfor må myndigheter forplikte seg til å dele utviklingen med alle andre land før utviklingen skjer. På den måten vil ikke ulike land og firmaer kjenne på en massiv konkurranse om å utvikle KI først, fordi de vil vite at hvem enn som utvikler KI først, så må de dele godene fra teknologien med hele veden.

Så mitt forslag er dette: En global konvensjon med en bred definisjon av «superintelligens». Mitt forslag er at vi definerer det som et system med bedre-enn-menneskelig intelligens, som for eksempel kan skrive PhD-oppgave innen informatikk, fysikk, matte og kjemi på et ledende universitet. Videre foreslår jeg at en kommisjon samles, med representasjon fra hele verden – det er kanskje uoppnåelig, men vi bør i hvert fall bevege oss i den retningen. Kommisjonen bør ha kontroll over KI-systemer, kunne styre utviklingen av dem og kontrollere hvor raskt utviklingen skjer. Dette forslaget ligner på Baruch-planen fra 1946, som forsøkte noe lignende da atomvåpen ble utviklet. Baruch-planen ble ikke gjennomført, men forslaget lå på bordet i sin tid.

Fra mitt langsiktige perspektiv ønsker jeg grundige debatter om alle valgene vi tar mens intelligenseksplosjonen pågår. Ideelt sett ville de pågått i århundrer, og kanskje tusener av år. Men for politisk gjennomførbarhet foreslår jeg at vi kan bremse utviklingen i ett år, i første omgang. Da vil vi kanskje kunne ha KI-assistert tenkning om dette. For KI kan hjelpe oss med disse problemene, samtidig som de er problemet. GTP-4 har allerede gode evner til å resonnere. Når vi får utviklet bedre modeller, kan de hjelpe oss i valgene vi må ta og sammenfatte enorme mengder med informasjon. På den måten kan vi ta bedre politiske valg med disse modellene. Dette er ikke noe jeg forventer skjer av seg selv, men det kan virkelig øke og forsterke vår visdom.

Konklusjon

Jeg har snakket mye om KI, intelligenseksplosjonen og hvordan fremtiden kan komme til å se ut. Men hvorfor er dette så viktig? Vel, jeg tror det er viktig fordi vi kan ha en veldig lang fremtid foran oss, og den kan være veldig god. Som sagt er fordelene fra KI enorme. Du kan kanskje aldri trenge å gjøre kjedelig dagsarbeid igjen, du kan kanskje aldri trenge å lide av de vanlige lidelsene som vanligvis plager menneskeheten. Det er virkelig mulig. Og mange av disse beslutningene er både veldig viktige, men også veldig vanskelige å reversere.

Som jeg sa, når en politisk leder har tatt makten og har kontroll over en automatisert militærstyrke, en automatisert politistyrke, kan du ikke virkelig gå tilbake fra det. Når du har et institusjonelt regime som har gitt eller ikke har gitt visse rettigheter til digitale vesener, er det veldig vanskelig å gå tilbake fra. Når noen land har tatt kontroll over romressurser og har all makt, er det veldig vanskelig å komme tilbake fra det. Og spesielt fordi AI-vesener i prinsippet kan leve evig, er dette en periode der beslutningene vi tar, tror jeg, ikke bare vil påvirke kommende år eller tiår, men kan påvirke århundrer, tusenvis av år, kanskje millioner av år, eller lenger.

Derfor er disse beslutningene så viktige, fordi de ikke bare påvirker den nåværende generasjonen, men også alle de som ennå skal komme. Antallet slike mennesker kan være enormt – selv med svært konservative estimater av menneskehetens levetid, vil fremtidige generasjoner overstige oss med mange tusen til én. Og deres interesser er like reelle, like viktige, som interessene til oss i den nålevende generasjonen. De får bare ikke oppmerksomhet, fordi de ikke kan stemme, skrive artikler og drive lobbyvirksomhet for seg selv. Så det er opp til oss, de av oss som er litt mer fremtidsrettet og villige til å ta moralske ideer på alvor, å tale deres sak og sørge for at vi er en generasjon som overlever intelligenseksplosjonen, forvalter den og styrer den på en ansvarlig måte for alle de menneskene som ennå skal komme.